Inhalt

Ein Teilnehmer in einem meiner KI-Workshops stellte kürzlich eine scheinbar einfache Frage:

„Darf ich Mitarbeitende überhaupt fragen, ob sie eine Aufgabe mit KI gemacht haben?”

Diese Frage hat mich nicht mehr losgelassen. Obwohl ich überzeugt bin, dass sie in dieser Form spätestens in zwei Jahren – wenn KI überall integriert ist – obsolet sein wird, bringt sie auf den Punkt, wie Künstliche Intelligenz Teamprozesse in der Tiefe beeinflusst: Es geht um Vertrauen, Verantwortung und Transparenz.

Insbesondere gerät das etablierte Verständnis darüber, was von wem, wann und wie gemacht wird, durch KI ins Wanken. Genau dieses gemeinsame Verständnis ist jedoch essentiell für die Entscheidungsfindung, Koordination und Zielerreichung von Teams.

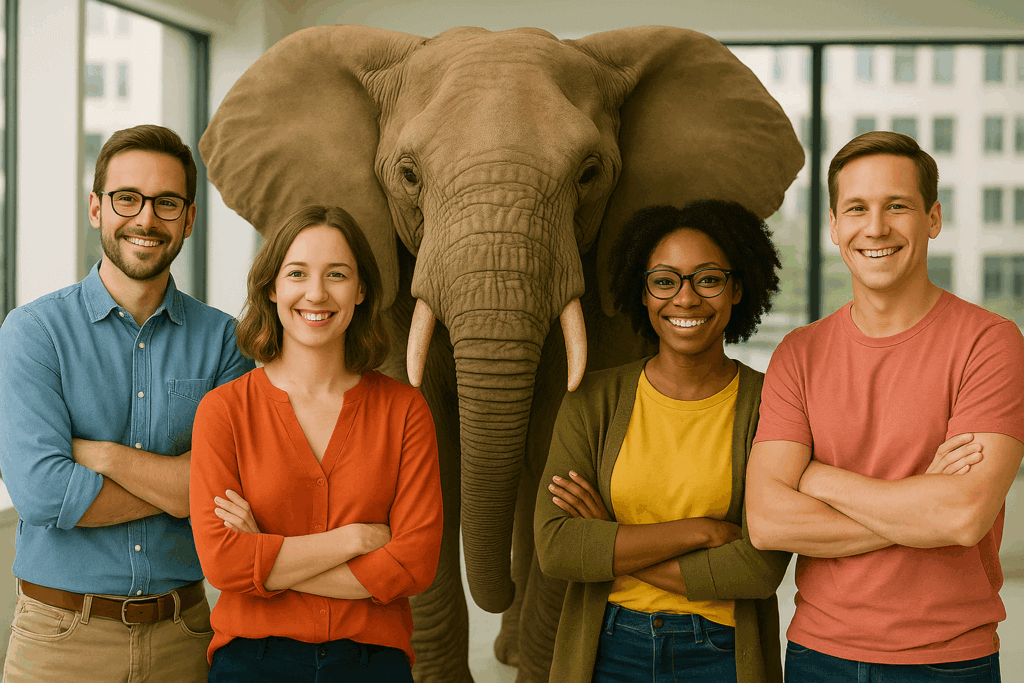

Brauchen wir, wenn KI in Teams genutzt wird, ein neues Verständnis von Zusammenarbeit, eine neue Teamkultur? Lasst uns den ”Elefanten im Raum” ansprechen.

Schneller haftet was Anrüchiges an

Das Tempo steigt, Vertrauen hinkt hinterher.

Dass die Frage des Workshopteilnehmers nicht von ungefähr kommt, belegt die aktuelle Studienlage. Während die Nutzung von KI bzw. GenAI (Generative Artificial Intelligence) in Unternehmen und Organisationen deutlich zunimmt – der Anteil der Nutzung von GenAI-Werkzeugen in mindestens einem Geschäftsbereich hat sich von ca. 27% in 2023 auf aktuell ca. 60% mehr als verdoppelt – hinkt das Vertrauen und die notwendige Kultur oft hinterher.

Die Studie von KPMG und der Universität von Melbourne (2025) dokumentiert zudem, dass in der Schweiz über zwei Drittel der Arbeitnehmenden (69%) den Einsatz von KI nicht deklarieren und Resultate als ihre eigene Arbeit ausgeben.

Diese mangelnde Transparenz wirft heute verschiedene Fragen auf: Hängt sie mit fehlenden Leitlinien zusammen? Mit der Hoffnung auf persönliche Vorteile? Oder mit Unsicherheit im Umgang mit der Technologie?

Unabhängig von den Gründen zeigt es, dass eine neue Kultur der Zusammenarbeit notwendig ist.

Blackbox KI

Die zentrale Herausforderung liegt darin, dass KI-Systeme – im Gegensatz zu menschlichen Teammitgliedern – intransparent und in ihrer Funktionsweise eine „Black Box” sind. Wir wissen nicht genau, wie KI eine Aufgabe erledigt, was davon übernommen oder ergänzt wurde und wie verlässlich das Resultat ist. Die Technologie wird zur Blackbox.

Zudem entwickeln sich KI-Systeme vom „passiven Werkzeug” zu „agentisch” agierenden Systemen. Sie können Aufgaben selbständig initiieren und bearbeiten. Wir haben es in der Folge mit „Teamkollegen” zu tun, deren Wissen und Prozesse wir nicht vollständig verstehen.

Trotz Abgabe von Kontrolle verbleibt die Rechenschaftspflicht beim Menschen. Es ist eine grosse Herausforderung, für einen Algorithmus verantwortlich zu sein, den man nicht kontrollieren und nicht vollständig verstehen kann.

In klassischen Teams ist klar: Wer macht was, wann, wie und mit welchem Ziel? Dieses gemeinsame Verständnis fehlt in der Regel, wenn KI ins Spiel kommt. Denn:

- Nicht alle im Team nutzen KI gleich intensiv.

- Die Kompetenz im Umgang mit KI ist unterschiedlich.

- Das Vertrauen in KI-Ergebnisse variiert stark – auch zwischen Hierarchien.

Das führt zu Spannungen: Misstrauen, stille Vorwürfe, Unsicherheiten in der Bewertung von Leistungen – weil ein gemeinsames Verständnis fehlt.

Dieses fehlende Verständnis untergräbt das Vertrauen in Teams und macht sie verletzlich. Diese Verletzlichkeit muss offen besprochen werden – denn nicht alle erleben KI gleich: Die einen sehen sie als Held, andere als Bedrohung oder Partner.

Damit Mensch und KI gut zusammenarbeiten können, braucht es ein ausgewogenes Vertrauen. Das heisst: nicht blind alles an die KI abgeben und nicht grundsätzlich ablehnen. Dieses Vertrauen entsteht nicht von allein – es braucht klare Schritte und gemeinsame Regeln.

Gestaltungsfelder für Vertrauensaufbau

- Transparenz und Verständlichkeit

Mitarbeitende müssen KI-Ergebnisse verstehen und nachvollziehen können. Dies erfordert Wissen über die Fähigkeiten und Grenzen der Systeme: Das „Explainable AI” (XAI) Prinzip ist hier entscheidend. - Einbeziehung und Partizipation

Frühe Einbindung der Mitarbeitenden in KI-Projekte stärkt Akzeptanz und Vertrauen. Praktische Testphasen helfen, Erfahrungen aufzubauen und Skeptiker zu überzeugen. - Klare Rollen und Verantwortlichkeiten

Menschen behalten die Kontrolle; KI ist Unterstützung, keine Konkurrenz. Klare Rollenteilung verhindert Missverständnisse. Es braucht folglich im Team Qualifikationen, die Steuerung und Urteilsvermögen stärken. - Kommunikation, Werte und Fehlerkultur

Offene Kommunikation, ethische Diskussionen und konstruktiver Umgang mit Fehlern fördern Vertrauen und Akzeptanz. KI-Einsatz sollte transparent und lernorientiert thematisiert werden. - Qualifizierung und Kompetenzentwicklung

Neue Kompetenzen sind nötig: digitales und technisches Verständnis, kritische Analyse von KI-Ergebnissen und kontinuierliches Lernen. - Nachvollziehbarer Mehrwert

Vertrauen entsteht, wenn der praktische Nutzen der KI für das Team klar sichtbar und fühlbar ist.

Risiko: De-Skilling-Effekt

In der Teamführung ist es wichtig, De-Skilling-Effekte kritisch zu beobachten. Wenn Mitarbeitende sich stark auf KI verlassen, kann die menschliche Kompetenzentwicklung stagnieren. Studien legen nahe, dass die Nutzung von GenAI-Werkzeugen die Fähigkeit verbessern kann, Aufgaben ausserhalb der Kernkompetenzen zu bearbeiten. Die KI wirkt dabei jedoch wie ein „Exoskelett”; es findet keine intrinsische Kompetenzentwicklung statt.

Wenn Mitarbeitende sich stark auf die Unterstützung durch KI verlassen und die zugrunde liegenden Fähigkeiten nicht mehr trainieren oder entwickeln, besteht das Risiko, dass Fachwissen verloren geht oder gar nicht erst entsteht.

Fazit: Fragen stellen ist kein Misstrauen – sondern Kulturarbeit

KI bringt Tempo – aber auch Unsicherheit. Wir müssen uns neu zusammenraufen und im Team aushandeln,

- wie wir arbeiten wollen,

- wer wofür steht und

- was als gutes Ergebnis gilt.

Dieser Aushandlungsprozess ist nicht lästig. Er gehört zur Teamarbeit.

„Hast du das mit KI gemacht?” – Diese Frage ist kein Angriff. Sie wird nur dann problematisch, wenn das Team noch keine Sprache dafür entwickelt hat. „Wie hast du KI eingesetzt?” signalisiert hingegen Interesse und ist ein Hinweis auf eine neue Teamkultur mit KI.

Quellen:

“From Tools to Teammates: Human-AI Teaming Success Factors in High-risk Industries”, NFP77 01.09.2020 – 31.08.2024, Nadine Bienefeld, Emanuela Keller

«Shall I Trust him’», Nadine Bienefeld und Shiko Ben-Menahem, Vortrag

Generative KI, Wissensarbeit & Personalentwicklung, SCIL Arbeitsbericht 34, Christoph Meier, Uni St.Gallen, 17. April 2025

Trust, attitudes and use of artificial intelligence: A global study 2025, KPMG und der Universität von Melbourne (2025)

Bienefeld N, Kolbe M, Camen G, Huser D and Buehler PK (2023) Human-AI teaming: leveraging transactive memory and speaking up for enhanced team effectiveness. Front. Psychol. 14:1208019. doi: 10.3389/fpsyg.2023.1208019

Ob Kommunikation, Kultur oder Kompetenzerweiterung – wir unterstützen euch in eurer Teamentwicklung!